近日,美国专利商标局正式授予苹果一项专利,该专利揭示了苹果未来头显在用户界面方面的发展,该用户界面将使用眼睛注视、触摸控制、手势、身体姿势甚至 Siri 进行交互。

苹果专利涵盖了使用眼睛注视/眼动追踪与头戴式设备(HMD)交互的技术。用户将能够用眼睛与 HMD 显示器上显示的用户界面对象进行交互。在一些示例性实施例中,这些技术通过允许用户主要使用眼睛注视和眼手势(例如,眼球运动、眨眼和凝视)来操作设备,从而提供了更自然和有效的界面。

该专利还描述了使用眼睛注视快速指定初始位置(例如,用于选择或放置物体),然后在不使用眼睛注视的情况下移动指定位置的技术。由于由于用户眼睛注视位置的不确定性和不稳定性,使用眼睛注视可能难以精确定位指定位置。

眼动追踪技术随后将应用于 Mac 台式电脑、MacBook、iPad 和 iPhone 等设备上的传统用户界面。这些技术对于计算机生成的现实(包括虚拟现实和混合现实)设备和应用程序也是有利的。

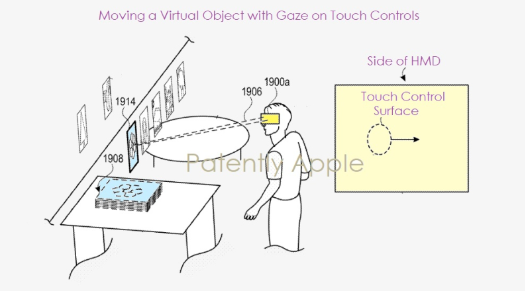

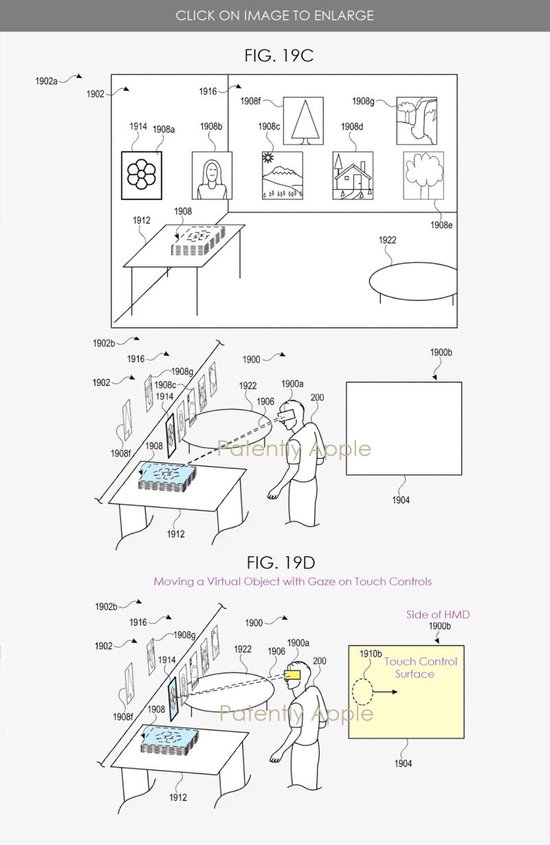

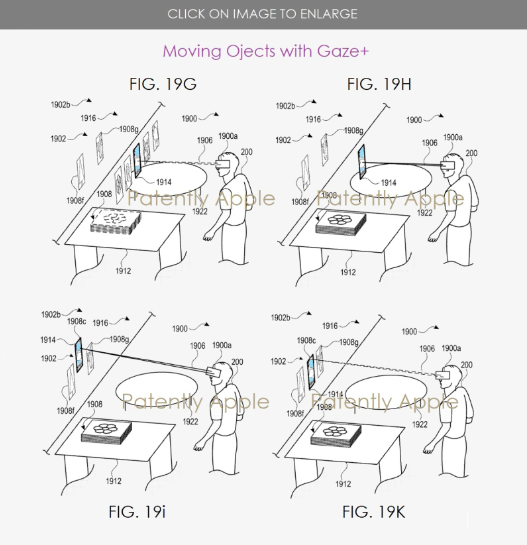

如专利图 19C 和 19D 所示,该专利描述了使用内置在 HMD 侧表面的注视控件和触摸控件与虚拟房间 #1902 进行交互并移动物体 #1908。

HMD 包括用于检测各种类型用户输入的传感器,包括(但不限于)眼部姿势、手部和身体姿势以及语音输入。在一些实施例中,输入设备包括被配置为接收按钮输入(例如,上、下、左、右、输入等)的控制器。

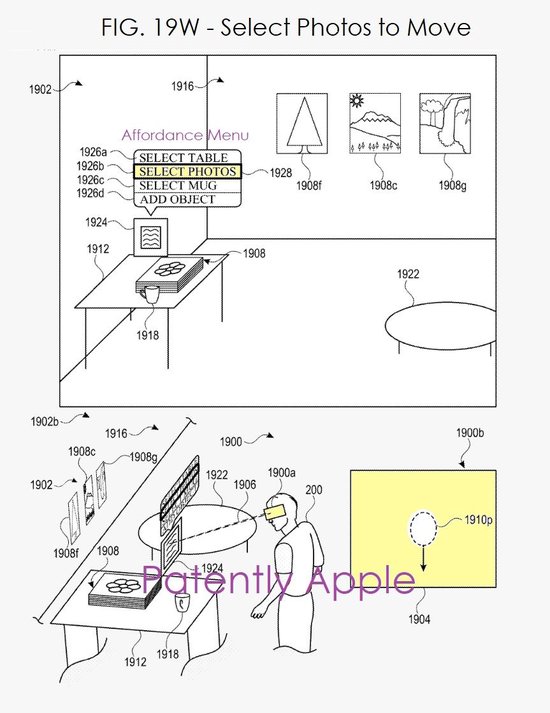

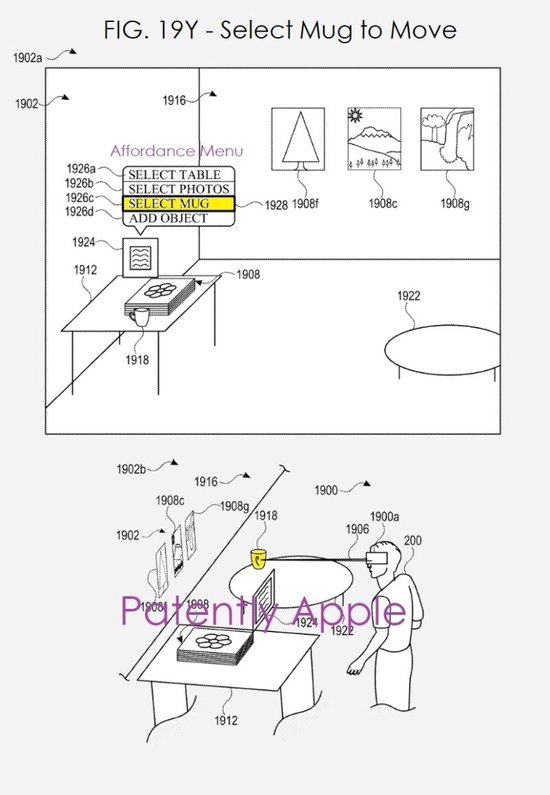

虚拟房间/环境 #1902 包括一堆照片 #1908,其中包括单张照片 #1908a-1908e。在视图 #1902b 中看到的注视 #1906 表明用户正在观看这堆照片。

照片 #1908a 的名称由焦点指示器 #1914 表示,其中包括照片 #1908a 周围的粗体边框。在一些实施例中,焦点指示器包括可视识别指定对象的指针、光标、点、球体、高亮、轮廓或重影。在一些实施例中,HMD 取消指定照片并将照片返回到桌面,以响应于接收进一步的输入(例如,选择退出按钮或取消触摸)。

在下面的专利图中,苹果说明了如何使用注视和触摸控件在虚拟环境中移动物品,例如绘画/照片,甚至是咖啡杯。

在专利中,苹果还指出 HMD 系统包括图像传感器,可选择包括一个或多个可见光图像传感器,如带电耦合器件(CCD)传感器,和/或互补金属氧化物半导体(CMOS)传感器,可操作以从真实环境中获取物理对象的图像。

图像传感器还可以选择地包括一个或多个红外(IR)传感器,例如被动红外传感器或主动红外传感器,用于检测来自真实环境的红外光。例如,主动红外传感器包括红外发射器,例如红外点发射器,用于向真实环境发射红外光。图像传感器 #108 还可选择地包括一个或多个事件摄像头,这些摄像头被配置成在真实环境中捕获物理对象的运动。

图像传感器还可以选择包括一个或多个深度传感器,这些深度传感器配置为检测物理对象与 HMD 系统的距离。在一些实施例中,HMD 结合使用 CCD 传感器、事件摄像头和深度传感器来检测 HMD 周围的物理环境。